MCP协议是什么?

你有没有想过,为什么现在的AI能查资料、算数学、甚至能给你发邮件?其实啊,它们背后都离不开一个叫做 MCP协议 的东西。这个协议就像是AI世界里的“USB-C”,让各种外部工具、数据源啥的都能通过同一个“接口”接入到大模型(LLM)里,让它们变得特别能干、特别聪明。

我们平时用的大模型,比如聊天机器人、写代码助手什么的,它们本身知识是有边界的。如果想让它们看实时数据、查外部文档、调用外部服务,那就得靠 MCP 出马啦。MCP 这个全名叫 “Model Context Protocol”,翻译过来就是“模型上下文协议”。名字听着有点拗口,其实说白了,它就是一个帮模型搞定“外联”的万能桥梁。

我觉得这个协议最大的亮点,就是它把各种繁杂的外部接口整合成了一个统一标准。你可以把它理解成是给AI打通了“外接神经系统”。

MCP到底是怎么做的?

先来看看 MCP 协议的核心理念——模型上下文(Model Context)。意思是让LLM在执行任务时,可以随时访问自己“身体”外的数据和工具,就像我们人类上网查资料、用计算器一样自然。

为此,MCP 定义了一整套规范,确保模型在和外部沟通的时候,有章可循:

- 接数据源:比如你有个数据库、一个API、或一个文档库,MCP就能让模型直接调取里面的数据,实时查看。

- 接外部工具:比如想让模型算一串复杂公式、查天气、发邮件?没问题,用 MCP 统统接进来。

- 接上下文管理器:比如多轮对话要保持连贯,MCP会帮模型动态记录对话历史,确保你不会被“记忆力差”的AI搞得心烦。

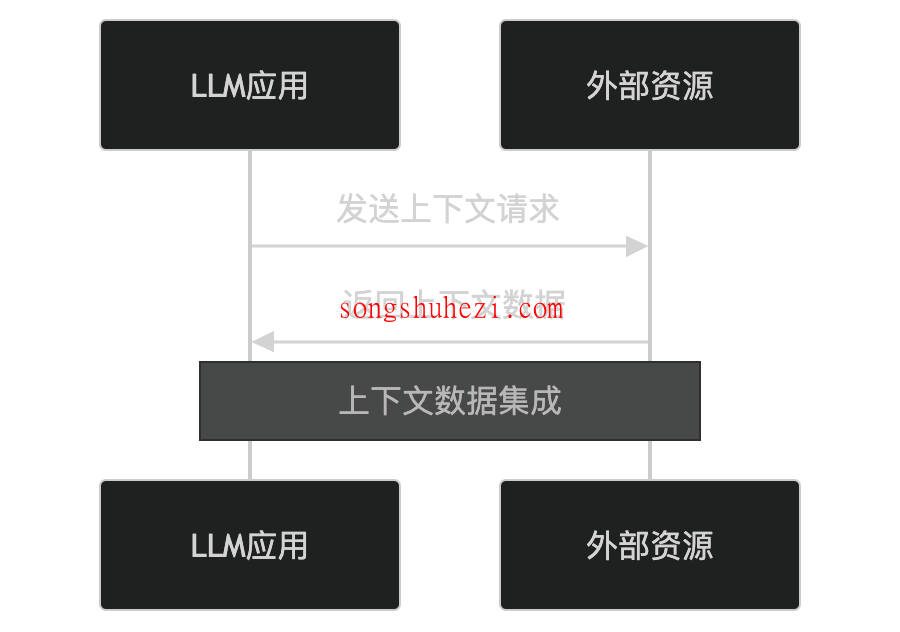

MCP的架构长啥样?

整个 MCP 协议的架构可以拆成四个部分,看起来有点像一个三明治中间夹个中介:

- 主机(Host):这就是我们平时用的AI应用,比如一个对话助手、一个智能IDE。它负责发起连接,调用功能,是整个系统的“老大”。

- 客户端(Client):主机的“传声筒”,它帮主机和服务器之间传消息,还负责能力协商、协议对接,保证沟通顺畅。

- 服务器(Server):外部服务提供者,比如Gmail、Slack的接口、或者一些数据处理工具,它们通过MCP协议被“接入”进来。

- 基础协议(Base Protocol):规定这三方怎么聊,聊什么格式、什么时候聊,保证大家说的是同一种“语言”。

这样的架构,有点像你在家用WiFi连电视、打印机那样——一个协议,统一管理各种设备,方便省事。

MCP具体怎么用?

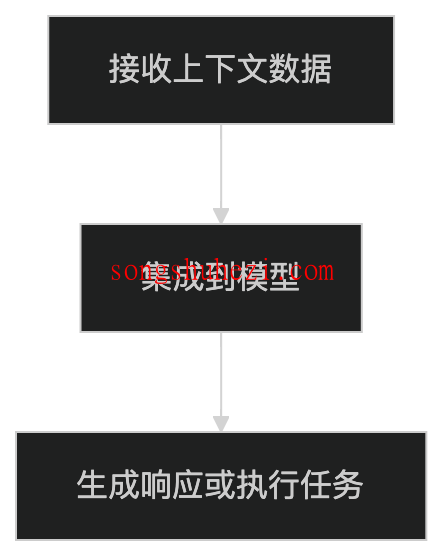

别担心,虽然听起来挺工程的,但它的操作逻辑其实挺直白的。流程就三步:

1. 上下文请求

模型发现自己“脑子不够用”了,比如用户问了一个实时天气的问题,它就通过 MCP 发出请求:“我需要今天天气数据”。

这时候,外部资源(比如一个天气API)收到请求,就乖乖返回数据。

2. 上下文集成

模型拿到数据后,不是死记硬背,而是像人一样“吸收”。把这些外部信息整合进自己的回答里,让回复更准确、更实用。

3. 上下文管理

如果是那种多轮对话,比如“上次那个电影你说不错,有没有票?”,模型要记得“上次是啥电影”。MCP这时候就提供一个“记忆小秘书”,专门管理这些上下文内容,确保聊天有前后逻辑。

技术底层也很扎实

MCP 用的是 JSON-RPC 2.0 作为消息格式,也就是说主机和外部服务聊的是“JSON语言”。它支持几种传输方式:

- 本地开发时用的

Stdio - Web应用里常用的

HTTP + SSE(Server-Sent Events)

这两个方式覆盖了大部分应用场景,无论你是搞桌面工具、网页服务、还是命令行小程序,都能轻松接入。

而且 MCP 协议还设定了完整的生命周期:初始化 → 运行 → 关闭,避免连着连着就断了或者出Bug的情况。

最后

用 MCP 的应用确实更聪明、更像“知道你要什么”的感觉。它不会只凭一知半解回答你,而是能调动外部的各种“外挂”,生成更专业、更实用的内容。

这对开发者来说简直就是个福音。以前接入一个外部工具可能要写好几百行代码,现在只要“接上协议”,一切都规范清楚,开发效率高太多了。

所以啊,如果你是做AI应用开发的,或者正在研究如何让大模型更懂你,那 MCP 协议肯定值得你研究一波。它就像给AI装上了一张“外接大脑的网卡”,模型不再是个封闭系统,而是能接触外部世界的超级助手。

说到底嘛,AI不再只是“会说话的百科”,而是能动手、能查资料、还能帮你干活的“万能小助理”,而这一切,MCP就是那个幕后英雄。