OpenLLM: 自助托管大型语言模型变得简单

OpenLLM 为开发者提供了一种简便的方式

直达下载

返回上一页

描述

OpenLLM 帮助开发者在本地和云端运行如 Llama 2 和 Mistral 等开源大型语言模型,支持 OpenAI 兼容的 API 端点,优化了服务吞吐量和生产部署。

介绍

OpenLLM 提供了一种易于使用的解决方案,使开发者能够在本地和云端环境中运行任何开源的大型语言模型。该平台支持广泛的开源语言模型,并提供与 OpenAI 兼容的 API 端点,以便于从您的 LLM 应用平滑过渡到开源 LLMs。

快速开始

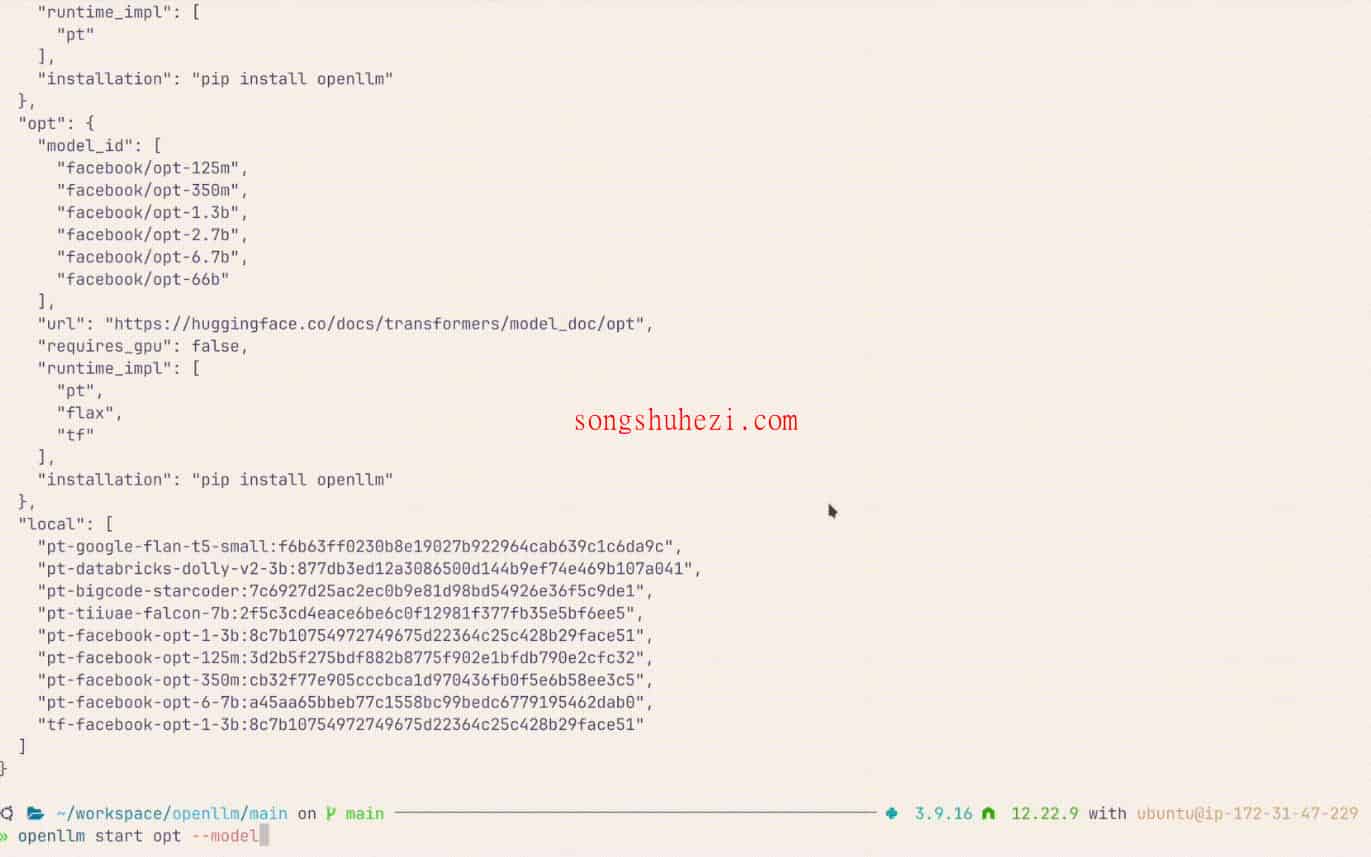

OpenLLM 提供了几种快速启动和尝试的方法,包括 Jupyter 笔记本和 Docker 容器。例如,您可以通过以下命令使用 Docker 快速启动 OpenLLM 服务:

docker run --rm -it -p 3000:3000 ghcr.io/bentoml/openllm start facebook/opt-1.3b --backend pt

如果您的系统配备了 GPU 并设置了 nvidia-docker,还可以使用 GPU 加速推理和优化:

docker run --rm --gpus all -p 3000:3000 -it ghcr.io/bentoml/openllm start HuggingFaceH4/zephyr-7b-beta --backend vllm

部署和使用

OpenLLM 的部署和使用非常灵活,支持通过命令行工具快速部署和启动服务。您可以安装 OpenLLM 并使用以下命令查看帮助信息或启动服务:

pip install openllm

openllm -h

此外,OpenLLM 支持多种模型和运行时,提供了量化和微调功能,以适应不同的性能和存储需求。

OpenLLM 不仅使部署过程变得简单,还通过优化模型运行配置大幅提高了效率。OpenLLM 兼容 OpenAI API,极大地简化了从其他模型向开源模型的迁移过程,使得我可以更专注于模型的应用和开发,而不是环境配置和管理问题。

×

直达下载

×

初次访问:反爬虫,人机识别