FastChat:开放的大型语言模型聊天机器人平台

FastChat 让每一次对话都变得更智能

直达下载

返回上一页

描述

FastChat 是一款专注于提供精选的大型语言模型(LLM)聊天机器人的培训、服务和评估的开放平台,每天处理超过百万次的聊天请求,为用户提供优质的聊天体验,支持多模型服务和兼容 OpenAI 的 API。

介绍

FastChat 是一个开放平台,专注于大型语言模型(LLM)聊天机器人的培训、服务和评估。它支持 Chatbot Arena,一个聚集了超过 70 种 LLM 的在线服务平台,已处理超过 1000 万的聊天请求,并收集了 50 万以上的人类投票,用于构建在线 LLM Elo 排行榜。此外,FastChat 提供了一系列核心功能,包括最先进模型的训练与评估代码、分布式多模型服务系统、网页 UI 和兼容 OpenAI 的 RESTful API。

FastChat 的核心特性

- 模型训练与评估:提供包括 Vicuna 和 MT-Bench 在内的最先进模型的训练和评估代码。

- 多模型服务系统:一个包含网页用户界面和 RESTful API 的分布式服务系统,支持多模型同时在线服务。

安装和使用 FastChat

安装方法

通过 pip 安装:

pip3 install "fschat[model_worker,webui]"从源代码安装:

git clone https://github.com/lm-sys/FastChat.git cd FastChat brew install rust cmake pip3 install --upgrade pip pip3 install -e ".[model_worker,webui]"

模型权重

FastChat 支持多种模型,如 Vicuna、LongChat 和 FastChat-T5。这些模型基于 Llama 2 构建,使用权重需遵循相应的许可协议。

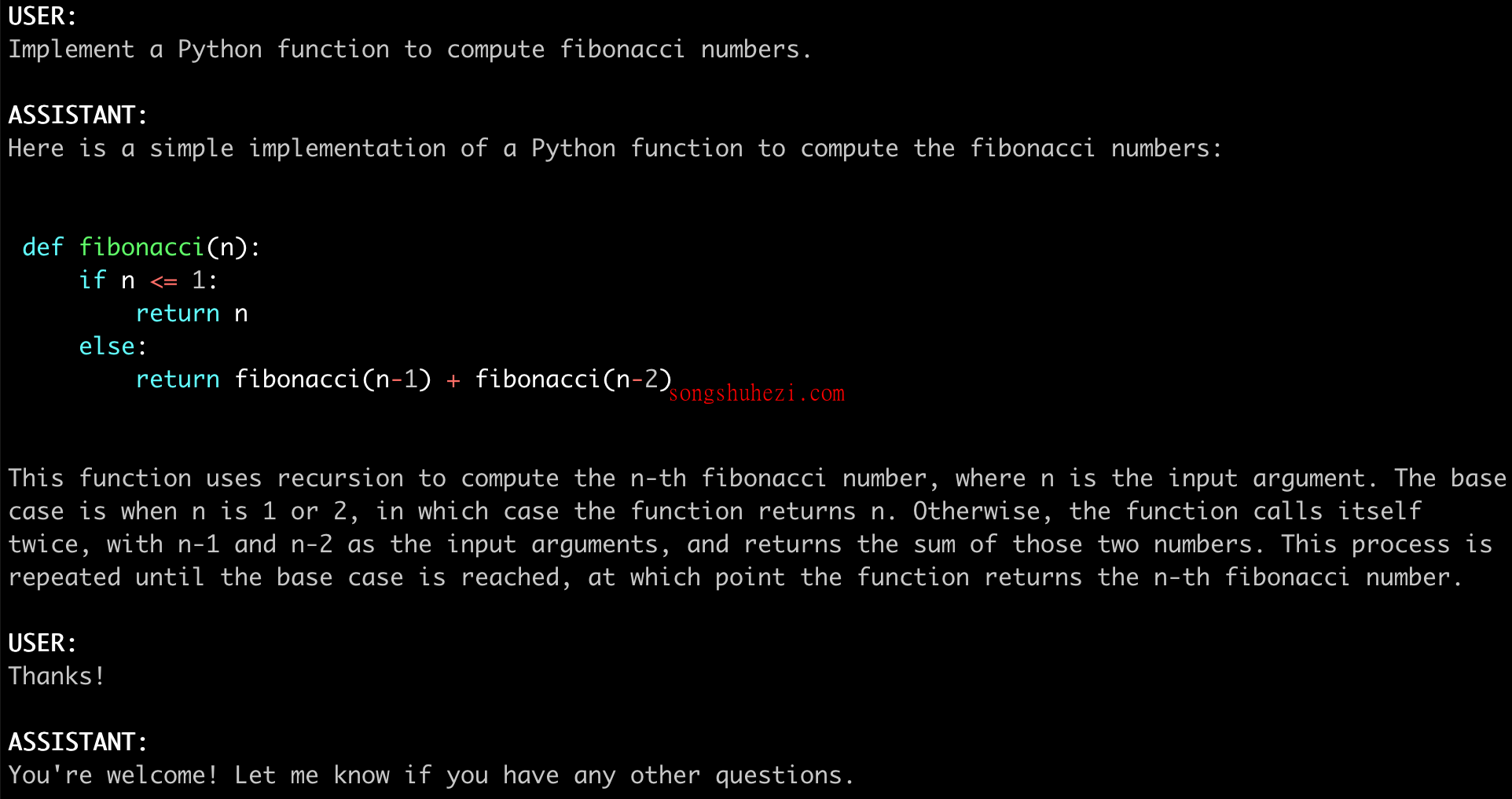

使用命令行界面进行推理

FastChat 支持命令行界面推理,兼容单 GPU 和多 GPU 环境,并提供 CPU 和其他硬件加速选项。例如,使用 Vicuna-7B 模型的命令如下:

python3 -m fastchat.serve.cli --model-path lmsys/vicuna-7b-v1.5

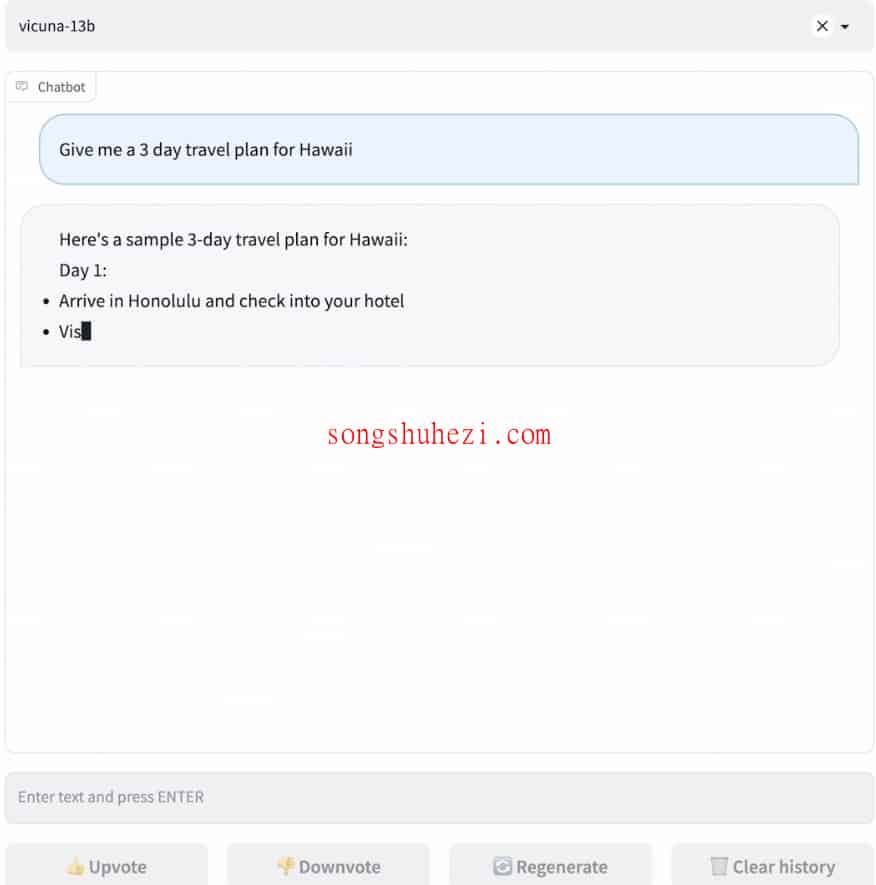

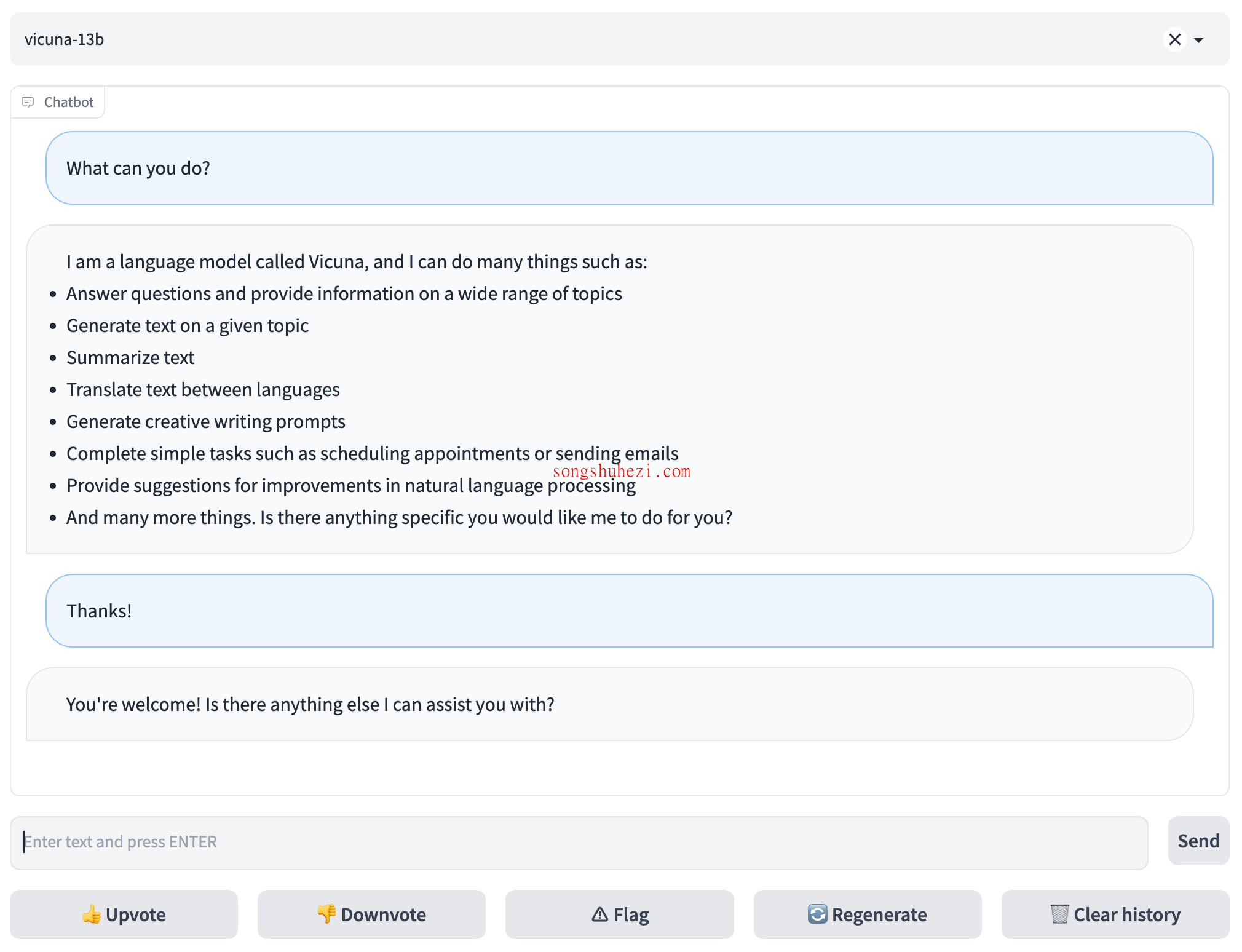

Web GUI 服务

要通过 Web UI 提供服务,您需要启动控制器、模型工作者和 Gradio Web 服务器。具体命令和步骤可在 FastChat 仓库的相关文档中找到。

FastChat 不仅提供了强大的技术支持和详尽的文档,还通过其多模型服务系统和兼容 OpenAI 的接口,极大地简化了大型语言模型聊天机器人的开发和部署过程,非常适合那些寻求在聊天机器人领域进行创新和改进的用户。

×

直达下载

×

初次访问:反爬虫,人机识别