Stanford Alpaca:遵循指令的LLaMA模型

详解Stanford Alpaca项目的技术细节、实际应用及其潜在影响

直达下载

返回上一页

描述

Stanford Alpaca是斯坦福大学开发的遵循指令的LLaMA模型,通过微调已有的大规模语言模型并利用新生成的指令数据,提供了一个强大的、可复现的研究工具,专为高效执行广泛的AI任务而设计。

介绍

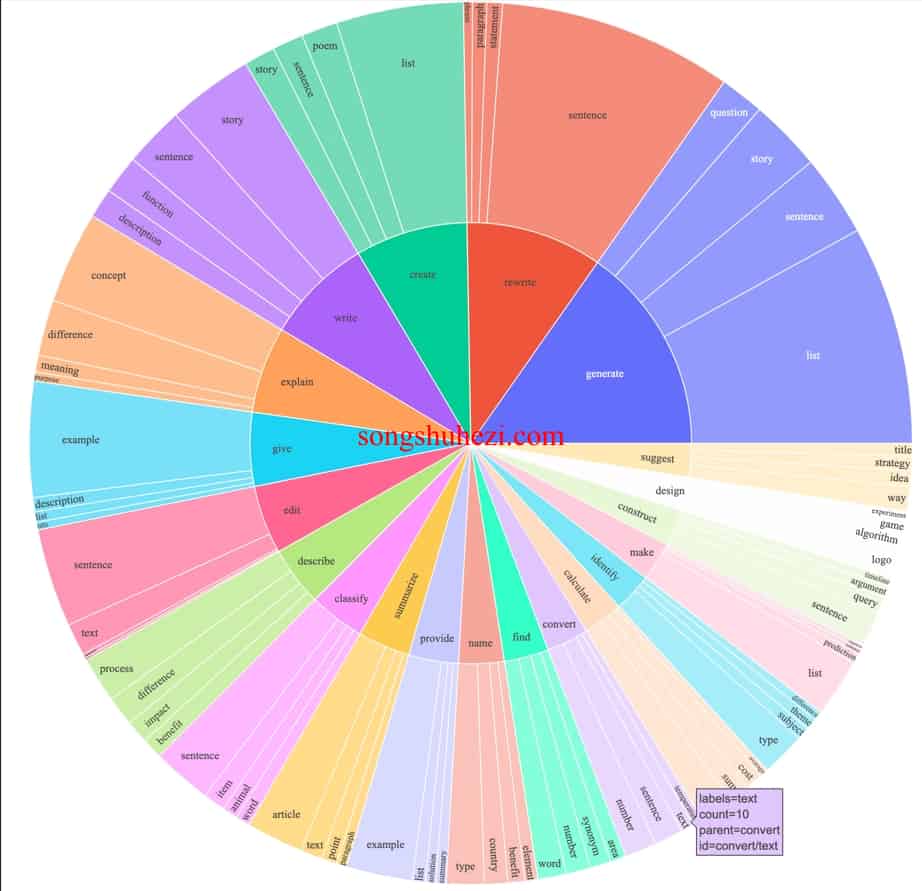

Stanford Alpaca项目旨在构建并共享一款遵循指令的LLaMA模型,该项目由斯坦福大学的研究团队开发。Alpaca模型基于7B参数的LLaMA模型进行微调,使用了52K条由最新技术生成的指令跟随数据。这些数据不仅覆盖了广泛的任务类型,还为模型的实际应用效果提供了坚实的基础。

项目内容与资源分享

- 数据生成代码:开源的数据生成代码让研究者能够复现或扩展数据集。

- 微调代码:公开的模型微调代码帮助用户根据自己的需求调整模型。

- 权重恢复代码:提供从发布的权重差异中恢复Alpaca-7B权重的方法。

此外,项目团队还分享了他们的训练配方和初步的人类评估结果,这些结果表明Alpaca 7B模型在执行指令跟随任务时的表现与OpenAI的text-davinci-003模型相当。

技术与训练细节

Alpaca模型的微调基于自生成指令的52K数据,这些数据由text-davinci-003生成,保证了内容的多样性和实用性。训练过程采用Hugging Face的标准训练代码,确保了过程的高效和模型的优化。

无论是数据处理、文本生成还是其他类型的任务,Alpaca都能给出精确并符合预期的回答。这种能力使其不仅适用于学术研究,还能助力于开发高级的AI应用程序,特别是在需要精确执行特定指令的场景中。

×

直达下载

RSS

RSS