Lit-LLaMA:开放源码的LLaMA实现探索

深入Lit-LLaMA的设计原则

直达下载

返回上一页

描述

Lit-LLaMA是一个完全开源的LLaMA模型实现,旨在提供一个不受GPL限制的、高性能的语言模型方案,适用于广泛的AI应用和研究。

介绍

Lit-LLaMA是一个独立的LLaMA预训练、微调和推理代码实现,完全开源并采用Apache 2.0许可证。此项目在nanoGPT的基础上构建,与原始的LLaMA模型权重兼容,这些权重由Meta在仅限研究的许可下分发。

设计原则

Lit-LLaMA的设计遵循几个核心原则:

- 简单性:实现简洁,无需复杂的配置。

- 正确性:与原始模型数值上等效。

- 优化性:能够在消费级硬件或大规模部署中运行。

- 开源性:完全开放源代码,没有任何附加条件。

如何使用Lit-LLaMA?

使用Lit-LLaMA非常简单:

- 克隆仓库并安装依赖。

- 下载模型权重(如果尚未拥有)。

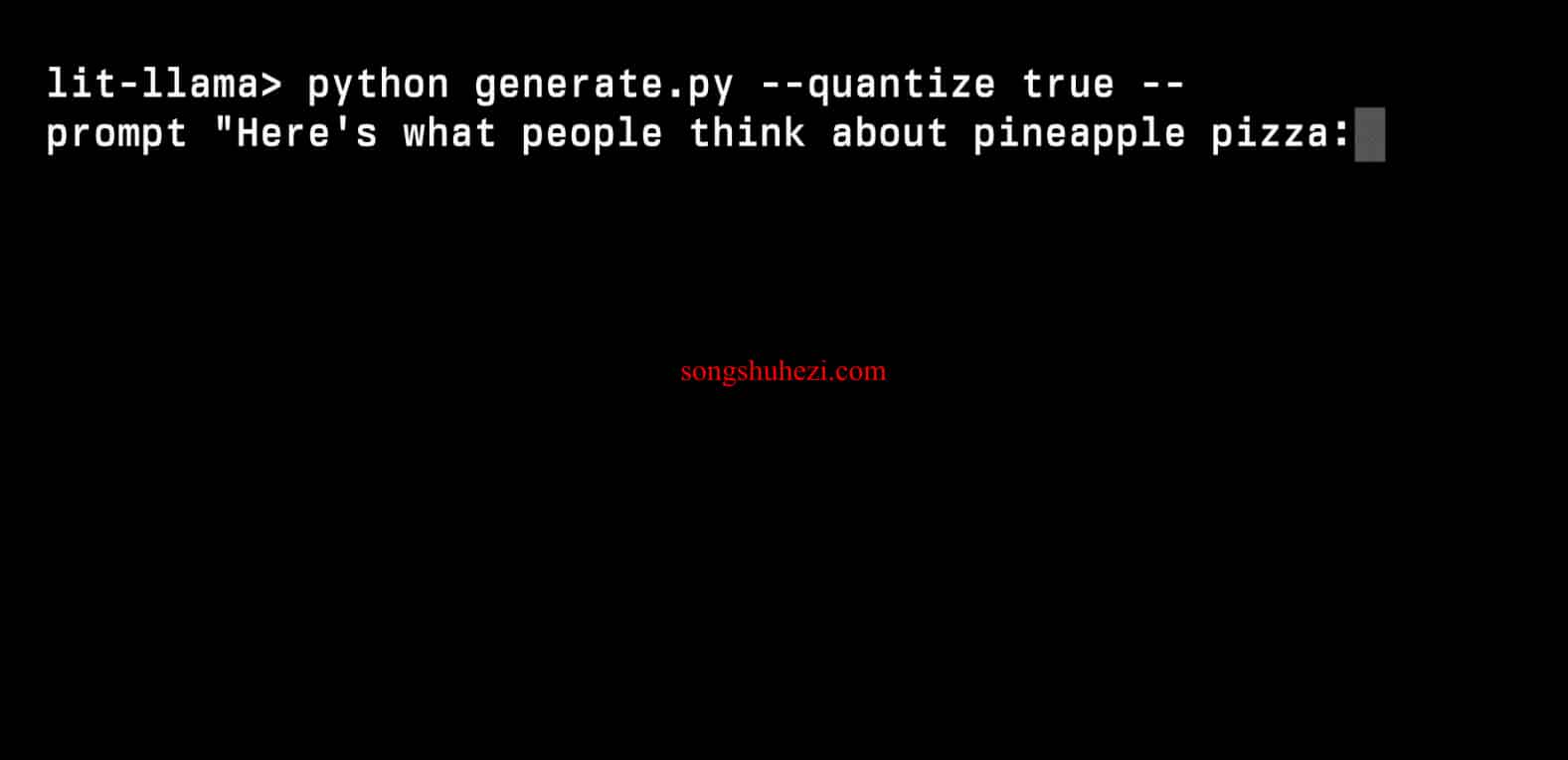

- 运行推理脚本生成文本,脚本支持多种量化选项以适应不同的硬件条件。

例如,在支持bfloat16的GPU上,运行生成脚本大约需要14GB的内存。

python generate.py --quantize llm.int8 --prompt "Hello, my name is"

对于内存较小或不支持bfloat16的GPU,可以启用量化(如int8或GPTQ-style int4量化)以减少内存需求。

从安装到执行,每一步都异常顺畅。生成文本的质量令人印象深刻,响应速度也非常快。尤其是在启用量化选项后,即便是在内存较小的设备上也能高效运行,这使得Lit-LLaMA非常适合在各种硬件上部署,包括消费级电脑。Lit-LLaMA社区的支持也是一个大亮点。加入Discord群组后,可以与其他开发者交流,共同解决问题并改进模型。

×

直达下载

RSS

RSS